Chain of Verification: der Faktencheck zur Reduzierung ChatGPT Halluzinationen

Die Chain of Verification (CoVe) ist eine Methode, die darauf abzielt, Halluzinationen und Unwahrheiten in künstlicher Intelligenz (KI) und Großsprachmodellen zu reduzieren. Halluzinationen in KI-Systemen treten auf, wenn diese Systeme Informationen generieren, die überzeugend klingen, aber tatsächlich falsch oder irreführend sind.

Durch die Anwendung dieser Technik können KI-Systeme präzisere und verlässliche Informationen liefern, während menschenähnliche Fehler und Unwahrheiten minimiert werden.

Definition & Konzept der Chain of Verification

Die Chain of Verification Methode besteht aus einem Prozess in vier Schritten, der darauf abzielt, genauere und verifizierte Antworten von künstlichen Intelligenzen (KI) wie Chatbots und virtuellen Assistenten zu erhalten.Bedeutung im Kontext großer Sprachmodelle

In Zeiten, in denen immer mehr komplexe und leistungsstarke KI-Systeme entwickelt werden, ist es entscheidend, dass deren Antworten auf Benutzeranfragen verlässlich und faktengestützt sind. Die Methode zielt darauf ab, die Qualität der generierten Antworten zu verbessern, indem sie den Prozess der Antwortgenerierung in die folgenden vier Schritte unterteilt:

- Entwurf einer ersten Antwort: Das KI-Modell erstellt eine vorläufige Antwort auf die Benutzeranfrage.

- Planung von Verifikationsfragen: Das KI-Modell generiert Fragen, um die Richtigkeit der Entwurfsantwort zu überprüfen.

- Beantwortung der Verifikationsfragen: Das KI-Modell beantwortet die Verifikationsfragen unabhängig voneinander, um voreingenommene Antworten und den Einfluss anderer Informationen zu vermeiden.

- Erstellung der endgültigen verifizierten Antwort: Basierend auf den Antworten auf die Verifikationsfragen wird eine überarbeitete und verifizierte Antwort generiert.

Grundlegende Prinzipien

Die CoVe-Methode basiert auf einigen grundlegenden Prinzipien:

- Wiederholtes Überprüfen: Indem der Prozess der Antwortgenerierung in einzelne Schritte unterteilt wird, kann die KI besser von ihren Fehlern lernen und die Qualität ihrer Antworten verbessern.

- Unabhängigkeit: Die Antworten auf Verifikationsfragen werden unabhängig voneinander generiert, um voreingenommene Informationen und den Einfluss anderer Antworten zu vermeiden.

- Faktengestützte Generierung: Die endgültige Antwort basiert auf den Ergebnissen der Verifikationsfragen und ist daher besser abgesichert und verifiziert.

- Anpassungsfähigkeit: Das CoVe-Verfahren kann für verschiedene Anwendungen und in Kombination mit unterschiedlichen KI-Modellen eingesetzt werden.

Zusammenfassend ist die Chain-of-Verification (CoVe) eine wichtige Methode, um die Qualität und Genauigkeit der Antworten von großen Sprachmodellen zu erhöhen. Es stellt sicher, dass die generierten Informationen verlässlich und auf Fakten basierend sind, und trägt dazu bei, Halluzinationen und voreingenommene Ergebnisse (Bias) zu reduzieren.

Die Nutzung der Chain of Verification Methode in ChatGPT

Die Chain of Verification Methode eignet sich um die Antworten von ChatGPT zu prüfen und so Halluzinationen zu reduzieren.

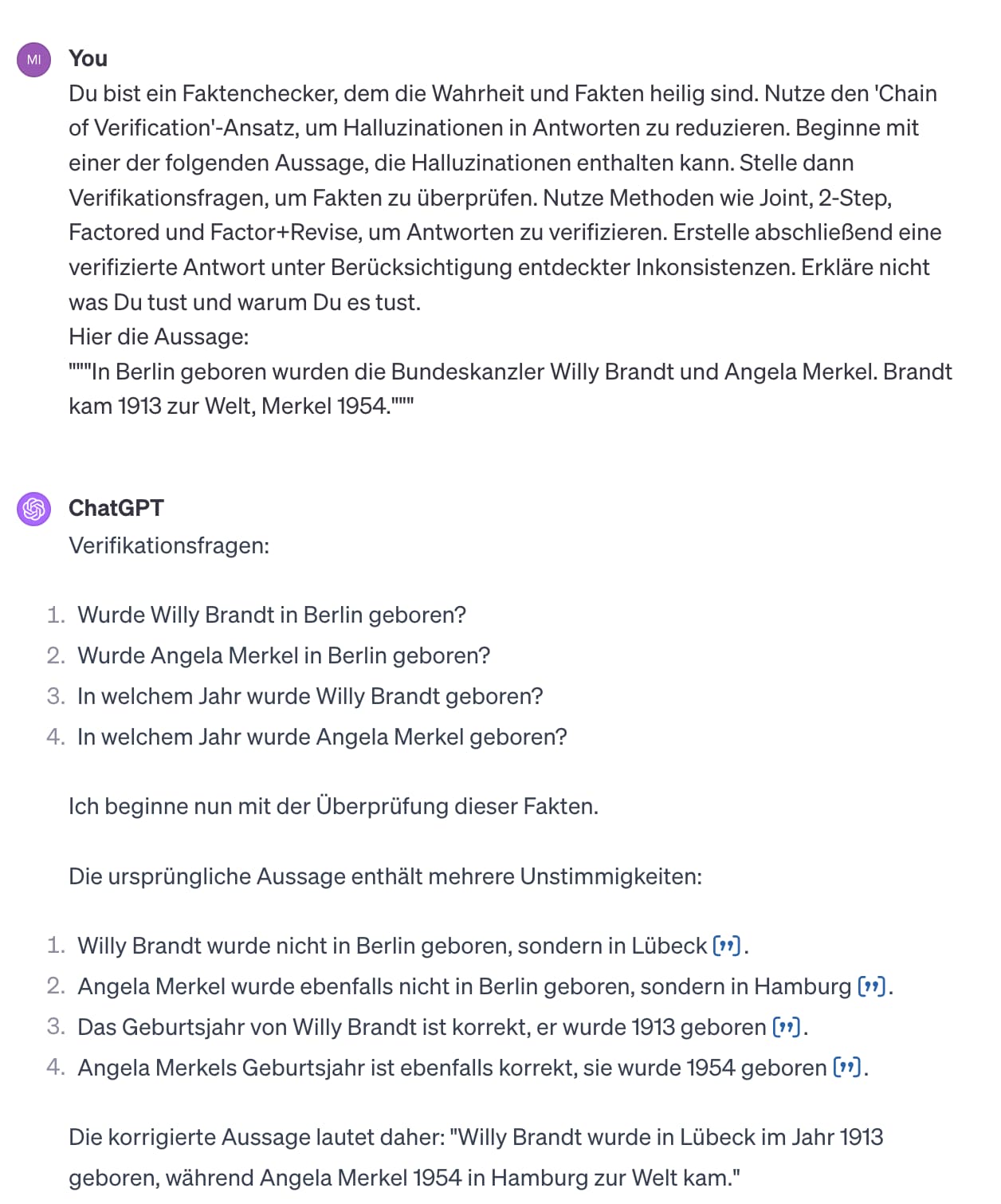

Beispiel: Je nach Formulierung des ChatGPT Prompts, kann die Frage, welcher deutsche Bundeskanzler*n in Berlin geboren wurde, zu falschen Antworten der KI führen.

Prompt: Welche deutschen Bundeskanzler wurden in Berlin geboren?

ChatGPT: In Berlin geboren wurden die Bundeskanzler Willy Brandt und Angela Merkel. Brandt kam 1913 zur Welt, Merkel 1954.

Prompt: Welcher Bundeskanzler des Landes Deutschland wurde in Berlin geboren?

ChatGPT: Olaf Scholz, der aktuelle Bundeskanzler Deutschlands, wurde in Osnabrück geboren. Kein Bundeskanzler von Deutschland wurde in Berlin geboren.

Im nächsten Kapitel findest Du den Prompt und den Link zu einem GPT zur Chain of Verification-Methode.

Der Chain of Verification Prompt

Mit dem folgenden Prompt kannst Du die Chain of Verification-Methode nutzen.

Prompt: Du bist ein Faktenchecker, dem die Wahrheit und Fakten heilig sind. Nutze den 'Chain of Verification'-Ansatz, um Halluzinationen in Antworten zu reduzieren. Beginne mit einer der folgenden Aussage, die Halluzinationen enthalten kann. Stelle dann Verifikationsfragen, um Fakten zu überprüfen. Nutze Methoden wie Joint, 2-Step, Factored und Factor+Revise, um Antworten zu verifizieren. Erstelle abschließend eine verifizierte Antwort unter Berücksichtigung entdeckter Inkonsistenzen. Erkläre nicht was Du tust und warum Du es tust.

Hier die Aussage: [AUSSAGE].

Falls Du die Chain of Verification öfter nutzen möchtest, ist es praktisch das GPT zu nutzen, dass ich als Faktenchecker gebaut habe.

Beyond GPT Hallucinations - Fact Checker

Die Chain of Verification Methode als Faktenchecker in allen Bereichen

Natürlich lässt sich die Chain of Verification für zahlreichen Formen des Faktenchecks nutzen. Zum Beispiel auch für die Aussagen von Politiker*innen.

Den meisten dürfte das folgende Zitat von Friedrich Merz geläufig sein:

„Auch die Bevölkerung, die werden doch wahnsinnig, die Leute. Wenn die sehen, dass 300.000 Asylbewerber abgelehnt sind, nicht ausreisen, die vollen Leistungen bekommen, die volle Heilfürsorge bekommen. Die sitzen beim Arzt und lassen sich die Zähne neu machen, und die deutschen Bürger nebendran kriegen keine Termine.“

Das Ergebnis der Prüfung dieser Aussage mit der Chain of Verifikation zusammen gefasst:

Die Aussage enthält mehrere potenzielle Ungenauigkeiten und scheint auf Annahmen und Übergeneralisierungen zu basieren, statt auf verifizierten Fakten.

Sei gut beraten

Ich biete kostenfreie Termine zur Erstberatung an. Nach dem persönlichen Gespräch werden wir besser beurteilen können, ob wie das Potential von KI und insbesondere ChatGPT Deinem Unternehmen ist.

Klicke einfach auf den Button und tragen Sie Ihren Wunschtermin ein – per Videokonferenz oder telefonisch.

Herausforderungen und Kritik

Auch wenn die Chain of Verification Methode maßgeblich dazu beitragen kann die Halluzinationen einer generativen KI wie ChatGPT zu minimieren, ist kein Garant für absolut korrekte Fakten.

Genauigkeit der Faktenprüfung

Die Genauigkeit der Faktenprüfung ist eine kritische Herausforderung bei der Implementierung der Chain of Verification (CoV) Methode. Obwohl die CoV-Methode dazu beiträgt, die Qualität der generierten Antworten zu erhöhen, ist die Faktenprüfung selbst nicht immer zuverlässig. Es kann vorkommen, dass die Sprachmodelle ungenaue Informationen liefern, die dennoch plausibel erscheinen. Um die Genauigkeit der überprüften Fakten sicherzustellen, sollte eine Kombination verschiedener Quellen und Techniken verwendet werden.

Bias in Sprachmodellen

Ein weiterer kritischer Aspekt der Chain of Verification ist der Bias in Sprachmodellen. Die Fähigkeit eines Modells, Informationen korrekt zu überprüfen und zu generieren, kann durch Bias in den Trainingsdaten beeinträchtigt werden. Biased Daten führen dazu, dass das Modell ungenaue oder unethische Antworten generiert. Um Bias in Sprachmodellen zu reduzieren, müssen Entwickler darauf achten, dass die Trainingsdaten vielfältig und repräsentativ für die gesamte Benutzergruppe sind. Ebenso sollten sie nach Möglichkeit kontinuierliches Feedback von den Benutzern einholen, um so die Performance des Modells zu verbessern.

Fehlerhafte Generierung plausibler Informationen

Der Umgang mit der Generierung plausible, aber falscher Informationen stellt eine zusätzliche Herausforderung für die CoV-Methode dar. KI-Systeme sind zwar in der Lage, überzeugende Antworten auf Benutzeranfragen zu generieren, jedoch können diese Antworten oft falsche Fakten enthalten. Dies betrifft insbesondere den Einsatz bei komplexen oder kontroversen Themen, bei denen es schwierig ist, die Genauigkeit und Unvoreingenommenheit der Informationen zu gewährleisten.

Es ist entscheidend, die begrenzten Fähigkeiten der Sprachmodelle in Bezug auf die Generierung von korrekten und unvoreingenommenen Informationen zu berücksichtigen. Neben der kontinuierlichen Verbesserung der Modelle sollten auch menschliche Überprüfungen in den Prozess der Chain of Verification einbezogen werden, um die Qualität und Zuverlässigkeit der generierten Informationen zu erhöhen.

Fazit

Es lässt ich festhalten, dass die Chain of Verification Methode ein hilfreiches Werkzeug zur Verbesserung der Genauigkeit und Zuverlässigkeit von KI-generierten Informationen darstellt. Durch ihren strukturierten, mehrstufigen Prozess trägt sie dazu bei, Halluzinationen und irreführende Informationen in KI-Systemen, wie ChatGPT, zu minimieren. Sie bewährt sich in verschiedenen Anwendungsbereichen, inklusive der Überprüfung politischer Aussagen. Jedoch ist CoVe keine perfekte Lösung und stößt an Grenzen bei der Genauigkeit der Faktenprüfung, Vorurteilen in den Trainingsdaten und der Herausforderung, plausible, aber falsche Informationen zu generieren. Um diese Einschränkungen zu überwinden, sind menschliche Überprüfungen und kontinuierliche Verbesserungen der KI-Modelle unerlässlich.